一、高性能升级前必读

高性能云产品从601升级到602,需要跟随平台602升级到平台611升级。平台升级到重启节点时,需要单独升级高性能云产品到602。高性能602仅支持从高性能601升级,不支持跨版本升级。高性能602仅支持在平台611上运行。

EOS 6.1.1升级过程中需逐台重启节点,为保证云主机业务不中断,需在升级任务执行前,腾空一台高性能节点,已便腾挪业务虚机,保证重启节点时业务的连续性,流程如下:

在节点重启阶段:

重启腾空的节点A。

腾空的节点A重启完成后,然后把高性能节点B上的高性能云主机通过冷/热迁移的方式疏散云主机至腾空节点A,直到节点B腾空。

重复步骤1-2, 直到高性能节点全部重启成功。

平台完成升级后, 需要进行高性能节点的变更, 流程如下:

变更腾空的节点A

然后把高性能节点B上的云主机迁移到完成变更的高性能节点A上,直到节点B腾空。

重复步骤1-2, 直到高性能节点全部变更成功。

如果特殊情况客户环境不具备升级前腾空一台高性能节点的条件,且客户能接受业务云主机短暂停机,则腾空腾空高性能节点不是必要步骤,在重启节点时先关闭节点上云主机即可,节点重启后,等待平台完成升级,平台升级完成后,进行高性能节点的变更,变更完成后,再重启云主机。

二、高性能升级前置条件

平台从602升级到平台611, 且平台升级到重启节点阶段。

cinder的版本是cinder 6.1.1.

已腾空一台高性能节点(非必须)。

三、高性能升级前准备

需要准备的软件:

| 软件 | 架构 | 软件信息 | 获取方式 |

|---|---|---|---|

| (md5).es | arm | arm平台高性能602升级包 | 网盘获取 |

| (公司名+许可时间).lic | arm | arm平台高性能602的license | 联系供应商获取 |

| 变更单 | arm | arm平台升级完成后高性能的变更单 | 联系供应商获取 |

| (md5).es | x86 | x86平台高性能602升级包 | 网盘获取 |

| (公司名+许可时间).lic | x86 | x86平台高性能602的license | 联系供应商获取 |

| 变更单 | x86 | x86平台升级完成后高性能的变更单 | 联系供应商获取 |

实施需要提供的软件:

| 软件 | 架构 | 软件信息 | 获取方式 |

|---|---|---|---|

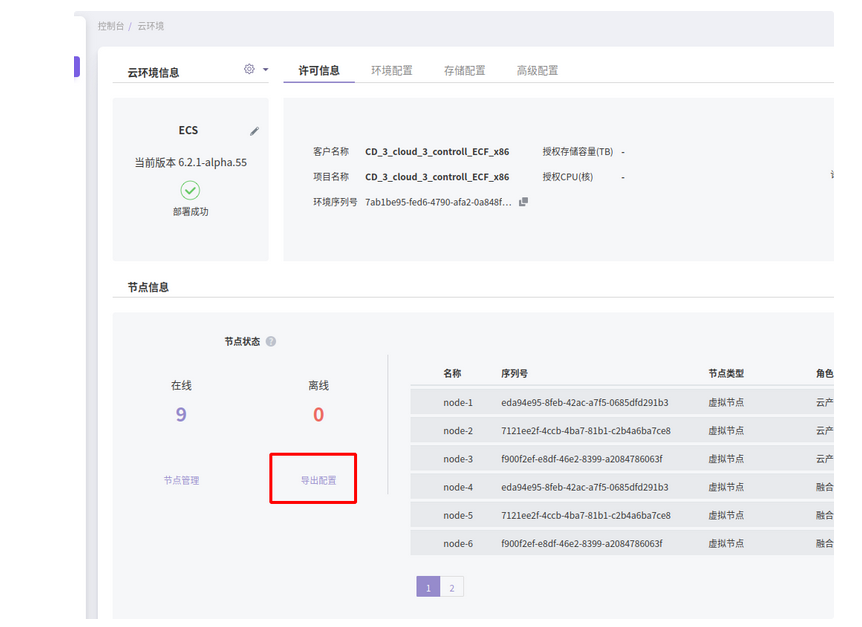

| node.data | arm | arm平台node.data信息 | 环境页面获取 |

| license.yaml | arm | arm平台高性能601的license | 环境后台获取 |

| node.data | x86 | x86平台node.data信息 | 环境页面获取 |

| license.yaml | x86 | x86平台高性能601的license | 环境后台获取 |

四、高性能升级步骤

步骤1:获取高性能601版本的license信息

- 进入控制节点,执行:

kubectl get config license -n ems -o yaml

- 把获取的信息保存下来,发送给制作lic的同事。

信息示例:

apiVersion: servicecatalog.ecp.com/v1

data:

cloud_product:

alcubierre:

ttl: 7258089600

values:

activation:

alcache:

- alcache_num: 6

group_id: 1

group_name: high-performance-1

nodes:

- cpu_lists:

- 18,19,20,21,22,23

- 24,25,26,27,28,29,30,31

- 32,33,34,35,36,37,38,39

- 40,41,42,43,44,45,46,47

- 48,49,50,51,52,53,54,55

- 56,57,58,59,60,61,62,63

node_disk: /dev/disk/by-path/pci-0000:02:00.0-scsi-0:2:3:0

node_ip: 52.168.30.2

node_name: node-1

vcpu_pin_set: 18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,101,102,103,104,105,106,107,108,109,110,111,112,113,114,115,116,117,118,119,120,121,122,123,124,125,126,127

- cpu_lists:

- 18,19,20,21,22,23

- 24,25,26,27,28,29,30,31

- 32,33,34,35,36,37,38,39

- 40,41,42,43,44,45,46,47

- 48,49,50,51,52,53,54,55

- 56,57,58,59,60,61,62,63

node_disk: /dev/disk/by-path/pci-0000:02:00.0-scsi-0:2:3:0

node_ip: 52.168.30.3

node_name: node-2

vcpu_pin_set: 18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,101,102,103,104,105,106,107,108,109,110,111,112,113,114,115,116,117,118,119,120,121,122,123,124,125,126,127

- cpu_lists:

- 18,19,20,21,22,23

- 24,25,26,27,28,29,30,31

- 32,33,34,35,36,37,38,39

- 40,41,42,43,44,45,46,47

- 48,49,50,51,52,53,54,55

- 56,57,58,59,60,61,62,63

node_disk: /dev/disk/by-path/pci-0000:02:00.0-scsi-0:2:3:0

node_ip: 52.168.30.4

node_name: node-3

vcpu_pin_set: 18,19,20,21,22,23,24,25,26,27,28,29,30,31,32,33,34,35,36,37,38,39,40,41,42,43,44,45,46,47,48,49,50,51,52,53,54,55,56,57,58,59,60,61,62,63,64,65,66,67,68,69,70,71,72,73,74,75,76,77,78,79,80,81,82,83,84,85,86,87,88,89,90,91,92,93,94,95,96,97,98,99,100,101,102,103,104,105,106,107,108,109,110,111,112,113,114,115,116,117,118,119,120,121,122,123,124,125,126,127

ceph:

cluster_network: 52.168.40.0/24

mon_host: 52.168.30.2,52.168.30.3,52.168.30.4

public_network: 52.168.30.0/24

ceilometer:

disable_feature:

- delete

ttl: -1

cinder:

disable_feature:

- delete

ttl: -1

glance:

config:

bootstrap:

images:

cirros:

source_url: http://coaster-all.openstack.svc.cluster.local:8880/roller/

disable_feature:

- delete

ttl: -1

grafana:

disable_feature:

- delete

ttl: -1

nova:

disable_feature:

- delete

ttl: -1

proton:

config:

conf:

plugins:

ml2_conf:

ovn:

dhcp_default_lease_time: "4294967295"

disable_feature:

- delete

ttl: -1

tag-crd:

disable_feature:

- delete

ttl: -1

license: eyJmb3VuZGF0aW9uX2Fya3MiOiB7fSwgImNsb3VkX3Byb2R1Y3QiOiB7ImNlaWxvbWV0ZXIiOiB7ImRpc2FibGVfZmVhdHVyZSI6IFsiZGVsZXRlIl0sICJ0dGwiOiAtMX0sICJub3ZhIjogeyJkaXNhYmxlX2ZlYXR1cmUiOiBbImRlbGV0ZSJdLCAidHRsIjogLTF9LCAiY2luZGVyIjogeyJkaXNhYmxlX2ZlYXR1cmUiOiBbImRlbGV0ZSJdLCAidHRsIjogLTF9LCAidGFnLWNyZCI6IHsiZGlzYWJsZV9mZWF0dXJlIjogWyJkZWxldGUiXSwgInR0bCI6IC0xfSwgImdsYW5jZSI6IHsiY29uZmlnIjogeyJib290c3RyYXAiOiB7ImltYWdlcyI6IHsiY2lycm9zIjogeyJzb3VyY2VfdXJsIjogImh0dHA6Ly9jb2FzdGVyLWFsbC5vcGVuc3RhY2suc3ZjLmNsdXN0ZXIubG9jYWw6ODg4MC9yb2xsZXIvIn19fX0sICJkaXNhYmxlX2ZlYXR1cmUiOiBbImRlbGV0ZSJdLCAidHRsIjogLTF9LCAicHJvdG9uIjogeyJjb25maWciOiB7ImNvbmYiOiB7InBsdWdpbnMiOiB7Im1sMl9jb25mIjogeyJvdm4iOiB7ImRoY3BfZGVmYXVsdF9sZWFzZV90aW1lIjogIjQyOTQ5NjcyOTUifX19fX0sICJkaXNhYmxlX2ZlYXR1cmUiOiBbImRlbGV0ZSJdLCAidHRsIjogLTF9LCAiZ3JhZmFuYSI6IHsiZGlzYWJsZV9mZWF0dXJlIjogWyJkZWxldGUiXSwgInR0bCI6IC0xfX0sICJsaWNlbnNlIjogeyJtYWludGVuYW5jZV9leHBpcmF0aW9uIjogIjIyMDAtMDEtMDEiLCAibWF4X2NwdSI6IDM4NCwgIm1heF9zdG9yYWdlIjogIjQ5VCIsICJtYWNoaW5lLW51bWJlcnMiOiBbIjIxMDYxMTMyNzFaWE1DMDAwMTU5IiwgIjIxMDYxMTMyNzFaWE1DMDAwMTU0IiwgIjIxMDYxMTMyNzFaWE1DMDAwMDUzIl0sICJjb21wYW55IjogIlx1NTMxN1x1NGVhY1x1NzI2OVx1NzQwNlx1NzNhZlx1NTg4MzUyIiwgInNvbHV0aW9uX3N0b3JhZ2UiOiB0cnVlLCAicHJvamVjdCI6ICJRQSIsICJleHBpcmF0aW9uIjogIi0xIiwgImFkZGluX2ZlYXR1cmVzIjogeyJzdG9yYWdlIjogeyJ2YWx1ZXMiOiB7InNvbHV0aW9uX3N0b3JhZ2UiOiB7InZhbHVlIjogdHJ1ZX19fSwgInJhbV9hbGxvY2F0aW9uX3JhdGlvIjogeyJ2YWx1ZXMiOiB7InJhbV9hbGxvY2F0aW9uX3JhdGlvIjogeyJlbmFibGVkIjogZmFsc2V9fX0sICJjcHVfYWxsb2NhdGlvbl9yYXRpbyI6IHsidmFsdWVzIjogeyJjcHVfYWxsb2NhdGlvbl9yYXRpbyI6IHsiZW5hYmxlZCI6IGZhbHNlfX19fSwgIm1heF9ub2RlIjogMywgInNlcmlhbCI6ICJmNTE2NjFjZi1mZGY5LTQ3YTYtYTQ3YS1lYzk2NTQzMDE2ZTYiLCAidHlwZSI6ICJub3JtYWwifSwgImluZnJhX3N3cyI6IHt9fQ==

topology: {}

kind: Config

metadata:

creationTimestamp: "2022-11-22T06:47:41Z"

generation: 11

name: license

namespace: ems

resourceVersion: "46631"

uid: ffa9f202-aae8-455d-95a8-c8b0f4dec61c- 把环境上的node.data导出来,发送给制作lic的同事。

在环境,产品与服务->自动化中心 导出node.data

步骤2:获取高性能602的云产品包和602版本的高性能license

请企业微信或电话联系云存储产品线负责人(陈超喆)审批,通过后,从网盘上下载高性能云存储602的包。

把环境的node,data信息和高性能601版本的license信息,发送给高性能制作license的人员,等待license制作完成。

步骤3:导入高性能602的包到平台内置ota

具体操作请参考: 高性能602部署手册, 部署流程第2步。

步骤4:更新高性能的license

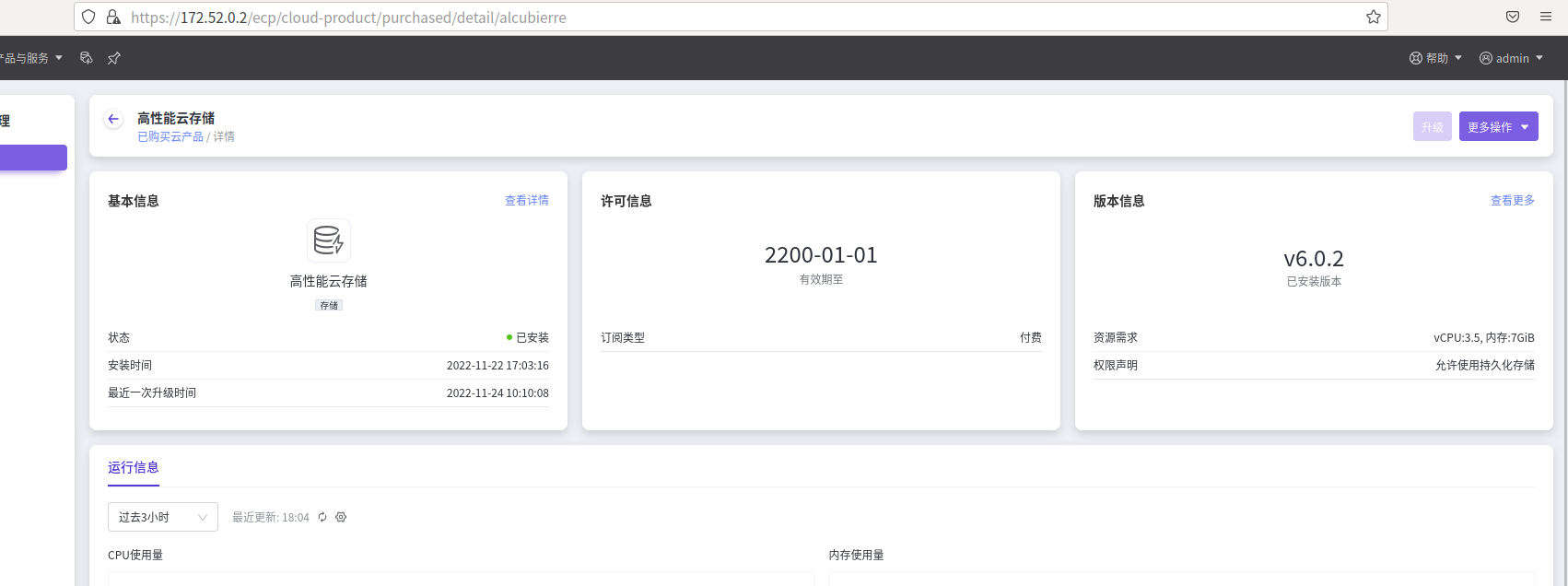

- 进入产品与服务—> 云产品, 选择高性能云存储。

- 点击高性能云存储—->管理,进入高性能云存储详情页。

- 点击更多操作—->上传许可,导入最新的高性能lic.

- 等待高性能lic导入完成。

步骤5: 升级高性能

高性能lic导入成功后,点击,升级按钮,等待高性能升级成功。

步骤6:重启高性能节点

高性能升级完成后,逐台执行重启高性能节点的操作。

节点设置“维护”模式前,可以通过批量热迁移方式将云主机迁移至其他节点;支持“压缩迁移数据”、“指定迁移网络”。

云主机热迁移时,需要确保云主机所在源节点和要迁移至目的节点的CPU指一样,您可以在自动化中心节点列表里确认节点CPU型号。

如果有腾空的高性能节点,首先重启腾空的高性能节点,然后把其他未重启节点的虚机,迁移到腾空的高性能节点,迁移完成后,重启节点。

如果没有腾空的高性能节点,首先把节点上的云主机关机,再进行重启节点的操作。

以下操作需手动介入处理,逐台节点进行操作。

节点重启流程,请参考eos611升级手册中节点重启流程。

步骤7: 等待平台完成升级,升级完成后,进行高性能节点的变更。

变更的前提:

变更的节点上无云主机或云主机处于关机状态

变更的影响:

迁移的虚拟机业务 io 会下降到当前 ceph 性能。

高性能对应的 ceph 的性能竞争会加剧。迁移完成后变更操作无影响。

迁移时,选择业务运行少的时段,且一台一台云主机迁移。耗时: 分钟级别。与对应 escache dirty 数据量有关,数据量越大,时间也会更久。

变更步骤请联系曾令钢获取变更单。

注意事项:

请确保需要变更的节点上的高性能存储的云主机都迁移到其它节点或是关机状态,否则变更操作会失败。

步骤8:升级完成

所有高性能节点变更完成后,高性能升级完成。